Google Kamera AI: Wie schafft die GCam so viel bessere Bilder?

Die Google Pixel Smartphones haben sich schon immer durch eine extrem starke Kamera trotz alter Hardware ausgezeichnet. Grund dafür ist die allseits bekannte Google Kamera-App, auch Google Kamera genannt.

Da fragt man sich natürlich, wie diese das hinbekommt. Demonstriert an einem Google Pixel 4 präsentieren wir Euch in diesem Beitrag zwei relevante Algorithmen von Google, die die Ergebnisse auf einzigartiger Weise verbessern.

Zum Abschnitt springen

Kamera-Kurztest – Wie gut sind die Ergebnisse wirklich?

Hardwareseitig verwendet Google bis heute noch den Sony IMX363 Hauptsensor aus dem Pixel 2 mit optischer Bildstabilisierung. Während das P50 Pro schon einen ein Zoll großen Sensor haben soll, bleibt es hier bei den klassischen 1/2,55 Zoll mit 12,2 Megapixel Auflösung.

- Hauptkamera Dynamikumfang gegen Huawei P40 (Bild: TechnikNews)

- Hauptkamera Farbwiedergabe gegen Huawei P40 (Bild: TechnikNews)

- Hauptkamera Farbwiedergabe gegen Huawei P40 (Bild: TechnikNews)

- Porträtmodus der Hauptkamera gegen Huawei P40 (Bild: TechnikNews)

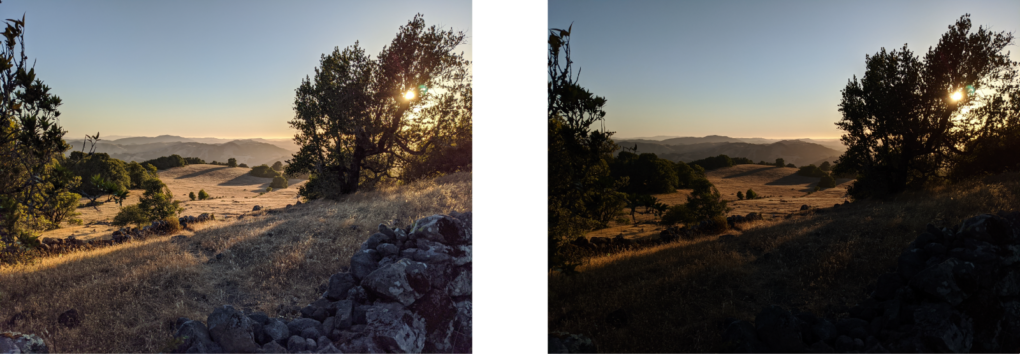

Zunächst fällt beim Betrachten der Ergebnisse auf, dass Google den Dynamikumfang richtig gut hinbekommen hat, denn mit der hellen Sonne kann das Pixel gut umgehen und auch die Farben sind dabei schön realistisch geblieben. Allgemein gefällt mir die Farbwiedergabe extrem gut, da es wie der perfekte Kompromiss zwischen real und künstlich wirkt.

- Bildschärfe der Hauptkamera gegen Huawei P40 (Bild: TechnikNews)

- Bildschärfe der Hauptkamera gegen Huawei P40 (Bild: TechnikNews)

Das Besondere ist immer noch die Bildschärfe. Hier spielt Google mit weniger Megapixel eine Liga über der Konkurrenz, ohne manuell zu überschärfen, was meistens nicht gut aussieht. Zudem wirkt sich das auch auf den besten digitalen Zoom aus. Bei einer zweifachen Vergrößerung ohne extra Linse kommt das Bild auf das Niveau eines Smartphones mit optischem Zoom.

Aber wie kann es sein, dass bei einer solch „schlechten“ Hardware solche guten Bilder herauskommen? Mit dieser Frage steigen wir in das Thema des Artikels ein.

Super Res Zoom – Wir bei Google brauchen nur 12 Megapixel

Die hohe Schärfe und der gute digitale Zoom sind der Technologie „Super Res Zoom“ zu verdanken. Hierbei handelt es sich nicht nur um das Zusammenfügen mehrerer Bilder, sondern um eine viel tiefgreifendere Technologie. Dabei ist besonders, dass Google das natürliche Wackeln der menschlichen Hand, die eigentliche Schwierigkeit beim mobilen Fotografieren, als Knackpunkt der Lösung anwendet. Das kam unerwartet. Im Folgenden erläutere ich, was genau gemeint ist. Das erste Problem, was zu lösen ist, sind die verlorenen Farbinformationen.

Farberkennung auf einem Kamerasensor

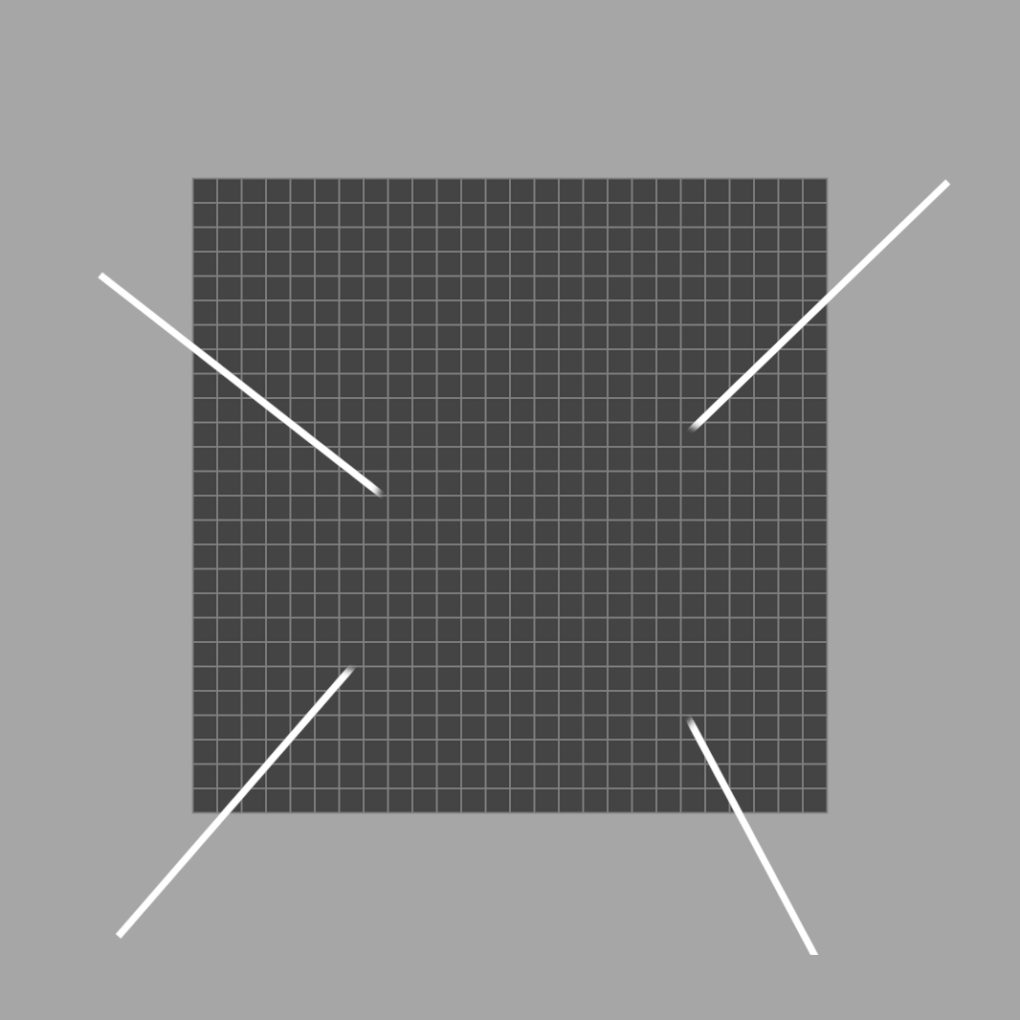

- Bild: TechnikNews

- Bild: TechnikNews

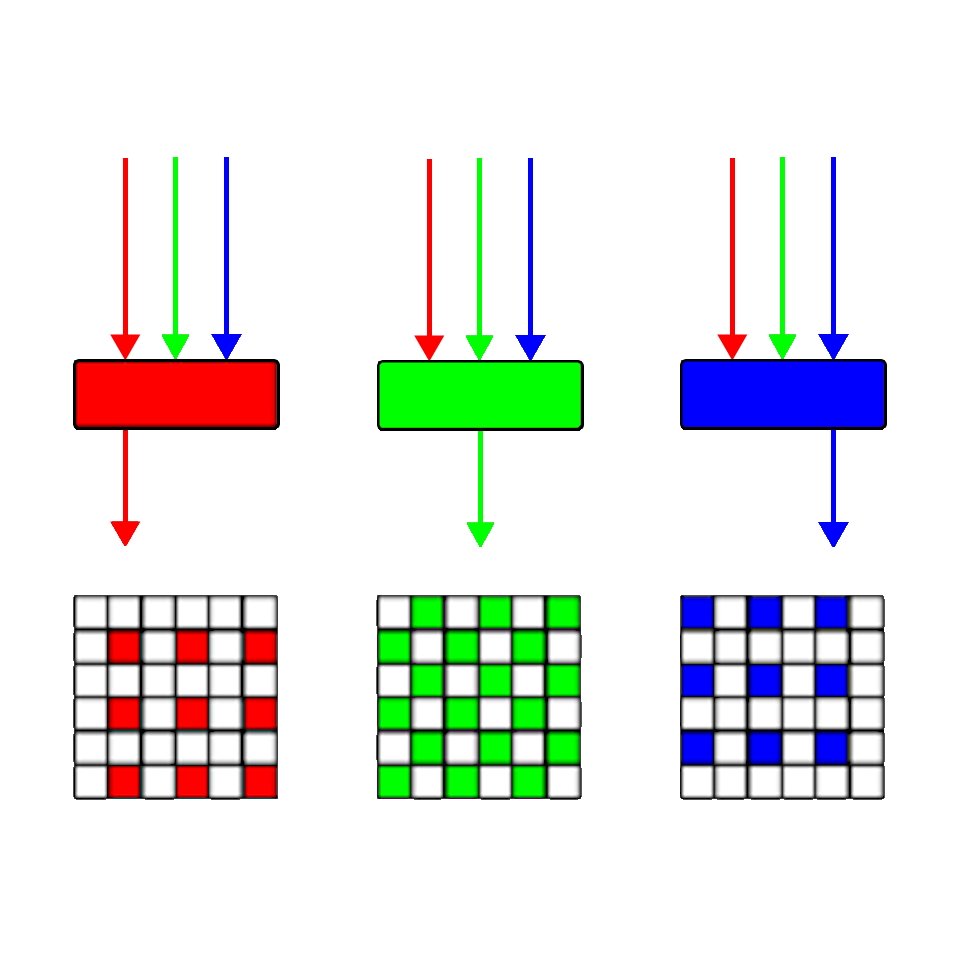

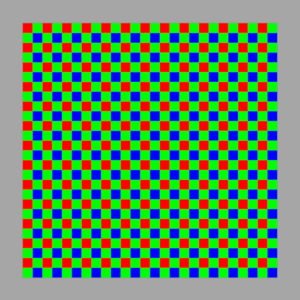

Der eigentliche Bildsensor kann keine Farben erkennen, nur die Stärke und Intensität der Lichtstrahlen, die auf ihn strahlen. Um die Farben in der Szene zu erfassen, verwenden Kameras Bayer-Farbfilter vor dem Sensor, sodass durch jeden Pixel genau eine Farbe – Rot, Grün oder Blau – durchkommt. Das Problem hierbei ist, dass jeder Pixel eben nur eine einzige Farbe erkennen kann.

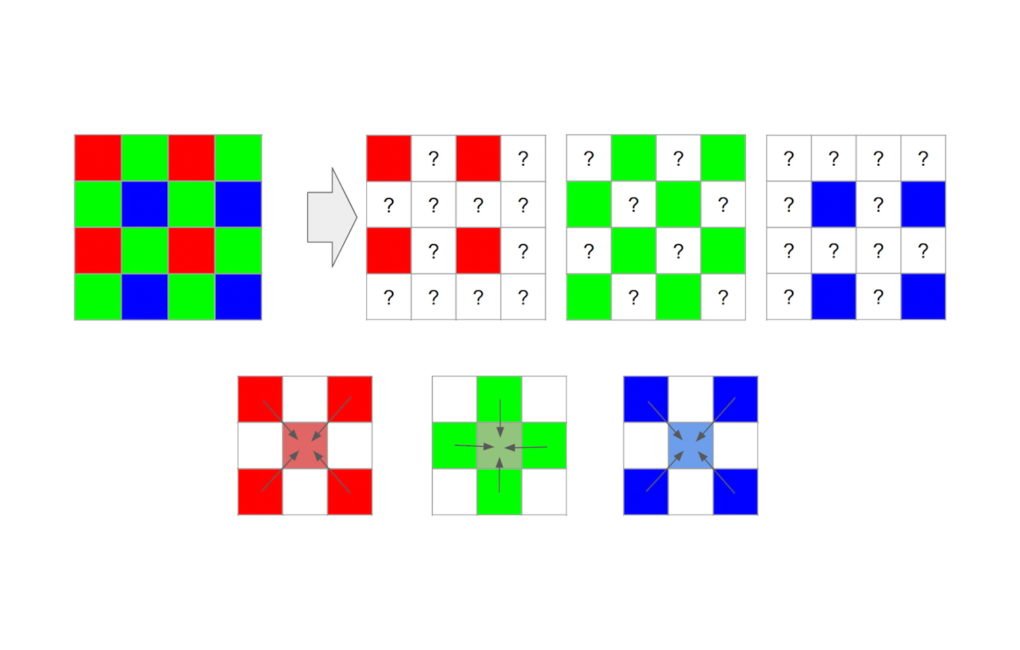

Hier muss die Kameraverarbeitungspipeline die realen Farben unter Berücksichtigung der Teilinformationen rekonstruieren. Das beschreibt ein Schätzen der fehlenden Farbinformationen durch die nahegelegenen Pixel. Zwei Drittel eines typischen RGB-Bildes sind eine Rekonstruktion. Diesen ganzen Vorgang nennt man dann Demosaicing.

Natürlich verwenden moderne Smartphones deutlich vollständigere Technologien als diese, dennoch führt das zu unvollständigen Ergebnissen und Artefakten. Das Problem haben selbst große DSLR-Kameras. Google hat eine gute Lösung gefunden.

Lösung für Artefakte bei Rekonstruktion

Seit mehr als einem Jahrzehnt kennt man die Technik Drizzle aus der Astronomie, wo Bilder vieler leicht verschiedener Perspektiven, besser gesagt Positionen, aufgenommen und kombiniert werden. Bei idealen Lichtverhältnissen entspricht das einer Auflösung eines zwei- bis dreifachen optischen Zooms.

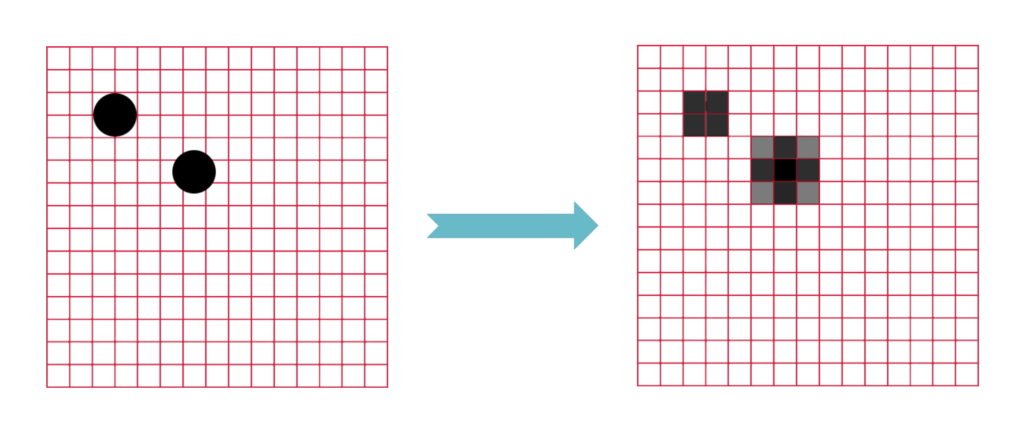

Die folgende Technik nennt man dann „Multi-Frame Super-Resolution“-Algorithmus. Um es zunächst einfach zu sagen, nimmt man sehr viele niedrig aufgelöste Bilder aus unterschiedlichen Perspektiven. Diese legt man in ein hochauflösendes Feld und erhält durch die Berechnung des Mittelwerts, also die Pixel, die bei jeder Perspektive belegt sind, ein hochauflösendes Bild.

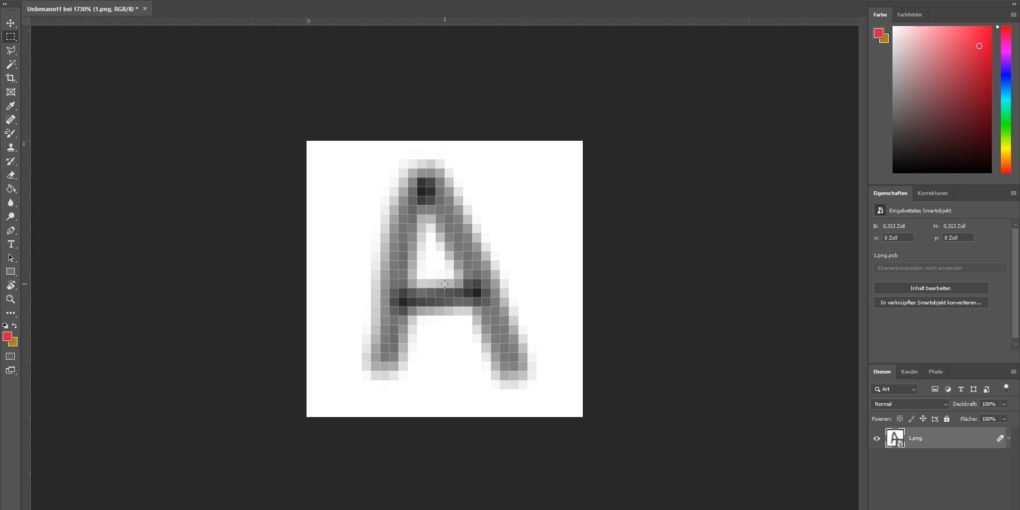

Skalieren wir das linke Bild oben mit zwei gleich großen hochauflösenden Kreisen auf eine niedrige Auflösung, so sehen wir: Es entstehen zwei unterschiedliche, niedrig aufgelöste Versionen des Kreises. Noch ein kleines Beispiel zur Demonstration: Ein hochauflösendes Bild des Buchstaben A habe ich einmal in verschiedenen Bilddateien unterschiedlich positioniert. Alle Bilder wurden anschließend auf eine extrem geringe Auflösung skaliert. Man erkennt auch hier, dass man viele unterschiedliche Versionen des Buchstaben erhält:

Alle Bilder habe ich nun in ein Bildbearbeitungsprogramm, in meinem Fall Adobe Photoshop, verschoben. Bei der Berechnung des Mittelwerts aller Bilder erkennt man: Das A ist wieder hochauflösend.

Ich habe dasselbe Verfahren auch einmal an dem von Google zur Verfügung gestellten Beispielbild durchgeführt und erhielt auch hier dasselbe Ergebnis.

- Vorher (Bild: Google AI Blog)

- Nachher (Bild: Google AI Blog)

Absichtliches Verwischen von Bildern?

Aber wie bekommt man nun die Aufnahmen aus leicht unterschiedlichen Perspektiven? Bei großen Kameras oder in der Astronomie gibt es dafür spezielle Technologien, aber bei mobiler Fotografie hat man einen sehr natürlichen Vorteil. Das unbewusste Wackeln der menschlichen Hand während dem Fotografieren. Durch diese leichten Bewegungen bekommt man viele Bilder aus unterschiedlichen Winkeln. Mit der optischen Bildstabilisierung werden dann noch zu starke Bewegungen ausgeglichen.

Wenn man dann aber ein Stativ verwendet und keine Verwacklung mehr hat, ist die künstliche Intelligenz dann wirklich am Ende? Nein, und das ist noch interessanter von Google gelöst. Sie bringen das Modul der optischen Stabilisation dazu, sich leicht zu bewegen. Eine Stabilisierung also, die zum Verwackeln verwendet wird. Diese Bewegung ist sehr klein und stört beim Fotografieren nicht, dennoch erkennt man sie, wenn man den digitalen Zoom des Pixel maximiert.

Warum nur Google?

Oben habe ich ein sehr flüssiges und scheinbar einfaches Schema erklärt, denn für die Verständlichkeit wurde dieses natürlich vereinfacht. Wenn jeder Schritt wirklich so perfekt funktionieren würde, hätte die Technologie wahrscheinlich bereits jedes Smartphone. Es gibt sicherlich Gründe dafür, dass es bisher nur Google gerissen hat.

Erstens ist bei einem Smartphone die Sensorgröße beschränkt. Selbst bei ausreichender Helligkeit kann es sein, dass aufgrund der zu niedrigen Belichtungszeit jedes Bild sehr viel Rauschen beinhaltet.

Zweitens: Beim Fotografieren kann sich neben der Hand auch noch das Motiv bewegen, zum Beispiel Blätter an einem Baum, Autos oder Mitmenschen. Das alles ist störend für „Multi-Frame Super-Resolution“. Zudem sind die Bewegungen der Hand und der Motive alle zufällig, selbst wenn die Bilder gut abgestimmt werden, können die Bildinformationen ungleichmäßig sein. Um den Rahmen nicht zu sprengen, belasse ich die Erklärung dabei. Wie löst denn das Google Pixel nun die Probleme?

Bewegungen im Bild vermeiden

Zunächst wählt es ein Bild aus den vielen Frames mit der besten Schärfe als Referenz aus. Anschließend werden die anderen Bilder mit diesem verglichen und analysiert. Das Vergleichen geschieht nicht einzelne Pixel für Pixel, sondern in größeren Bereichen. Damit sollen die gleichen Einstellungen wie bei dem Referenz-Bild (also die richtigen Einstellungen) gefunden werden. Erst danach werden die Informationen kombiniert.

Das war sogar noch nicht alles, denn das Google Pixel findet durch Software die Ränder von Objekten im Bild und kombiniert die Pixel besonders entlang dieser Ränder. So werden nicht nur die Details behalten, sondern die Ränder werden klarer.

Nach den oben aufgeführten Gründen lässt sich nun einfach erklären, warum unter gleicher Auflösung Google einfach mehr Details einfangen kann.

LiveHDR Plus – Aggressiver Dynamikumfang schon im Sucher

Beim Öffnen der Kamera-App auf einem Pixel-Smartphone sehen wir im View-Finder bereits das LiveHDR Plus angedeutet, wohinter die „HDR Burst“-Technologie steckt. Hier nimmt die Software schon im Sucher mit gleicher absichtlich niedriger Belichtungszeit Bilder auf und behält diese im Cache, einem temporären Speicher.

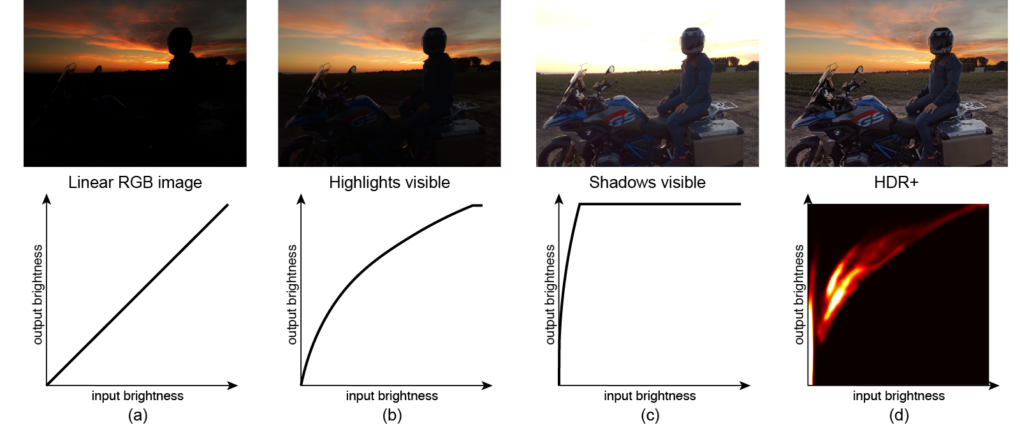

Die Bilder werden so kombiniert und gerendert, dass ein temporäres „Linear RGB Image“ mit 14-Bit-Farben und extrem vielen Details erhalten bleibt. Diese kann man aktuell jedoch aufgrund des zu niedrigen Dynamikumfangs noch nicht erkennen. Daher werden alle Pixel mit einer bestimmten (niedrigen oder hohen) Helligkeit einer neuen zugeordnet. So werden die Details auch sichtbar. Das HDR-Ergebnis hat am Ende Details sowohl in den Schatten, als auch in den hellen Bereichen des Bildes.

Bis zum Pixel 3 war es noch nicht möglich, diese Bilder in Echtzeit bei 30 Bildern pro Sekunde zu verarbeiten, also konnten sie sie nicht im Sucher anzeigen. Daher hat Google beim Pixel 4 LiveHDR Plus vorgestellt, welches simpel gesagt HDR Plus mit Echtzeitvorschau beschreibt.

Neu sind auch die zwei Helligkeits-Slider. Während der obere mit der Sonne als Symbol wie früher die Helligkeit des gesamten Bildes verstellt, kümmert sich der untere Slider um die Schatten – er hellt diese auf oder dunkelt nur diese ab.

Fazit

Das ist also die Google Kamera, zumindest ein relevanter Teil von ihr. Bei einem leichten Klick auf den Auslöser greift das Pixel hinter der Fassade auf künstliche Intelligenz und maschinelles Lernen zurück. Vielleicht die beeindruckendste Software auf dem Markt. Nun braucht man sich nicht mehr wundern, wie die Software das aus alter Hardware rausholen kann. Vielleicht ist das auch ein kleiner Spott an die anderen Android-Hersteller: „Ihr benutzt so krasse Hardware, weil ihr die Software überhaupt nicht in den Griff bekommt.“ Wenn ich mit dem soeben bekommenen Wissen einmal neu über das etwas asymmetrische Pixel 4 schaue, ist das ein Gefühl, bei dem ich die Ränder überhaupt nicht mehr sehen kann.

Quellen

Google AI Blog: Live HDR+ & Dual Exposure Controls

Google AI Blog: Super Res Zoom

Wow! Sehr gut recherchiert. Freue mich auf weitere so detailreiche Artikel hier zu lesen.

Hallo,

vielen Dank für die netten Worte! Sicherlich wird es bald wieder so einen Artikel geben.

Viele Grüße,

Yinan von TechnikNews

Danke für den tollen Artikel, sehr interessant!

Hallo David,

vielen Dank für die netten Worte, das freut mich!

Viele Grüße,

Yinan von TechnikNews